近日,上海交通大学电子信息与电气工程学院微米纳米加工技术全国重点实验室刘景全团队和上海交通大学人工智能学院卢策吾团队在人机交互领域取得重要进展,相关成果以“Capturing forceful interaction with deformable objects using a deep learning-powered stretchable tactile array”(使用深度学习驱动的可拉伸触觉阵列捕捉可形变物体的力学交互)为题,在国际著名期刊《Nature Communications》上发表。

研究背景

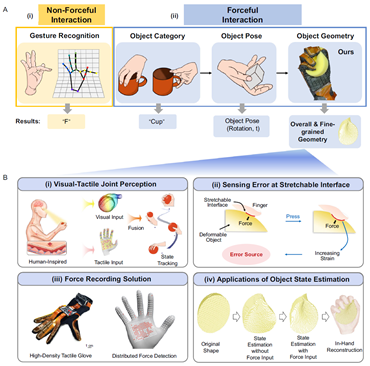

触觉感知是获取环境信息的重要渠道之一,在人机交互、虚拟现实、远程医疗和人形机器人等领域有重要研究价值。对于人形机器人而言,捕捉复杂操作任务中手与可形变物体之间的触觉数据并进一步估计手-物状态是一个巨大挑战。为解决上述问题,首先需要借助人机交互界面捕捉人类操作过程,再将经验迁移给机器人。传统的人机交互识别通常只能生成语义结果,如识别手势代表的字母,识别物体的种类和位置。因此,研究一种具有更高维度的精准、分布式人机交互界面,将有助于动态捕捉人类操作可形变物体的过程,这对推动人类通用操作能力向机器智能操作的迁移具有重要的研究价值和应用潜力。

亮点内容

该研究提出了一种全新的视觉-触觉联合记录和追踪系统ViTaM(Visual-Tactile recording and tracking system for Manipulation)。该系统配备了具有1152个力感知通道的柔性MEMS触觉手套,基于正/负拉阻效应克服了感知可形变物体时的应变干扰问题,实现了精准、分布式的触觉感知;同时,该研究通过视觉与触觉的联合深度学习,重建了动态的手-物操作状态,一定程度上促进了智能体在人机交互中的理解能力进步,尤其是在涉及力学交互的方面,向人类多模态感知的水平迈近了一步。

图1 深度学习驱动的触觉手套可捕捉与可形变物体的力学交互

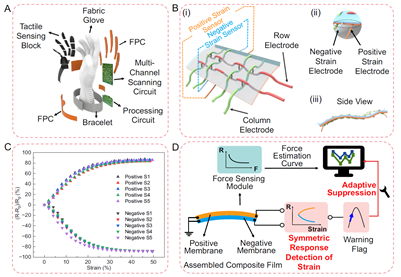

该团队研制的基于正/负拉阻效应的复合式薄膜,通过工艺调控,可以使得两种薄膜对所受应变表现出方向相反、幅值近似的电学特性,从而对双电极的对称响应实时检测,区分出传感器所受的压力与应变,并通过自适应校准输出电压与受力的关系曲线,最终达到对应变干扰的主动抑制效果。经测试,力测量精度达到97.6%,相较于未校准时提升了45.3%,这对精准感知可形变物体的受力具有较强的帮助。

图2 具有应变干扰抑制能力的触觉手套设计、制造和测试方法

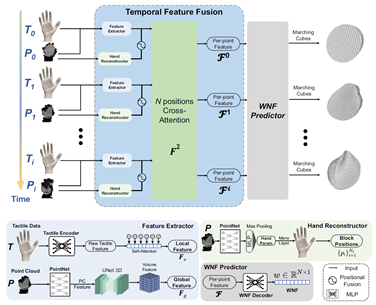

研究团队还提出了一种视觉-触觉联合深度学习框架,旨在处理多模态数据序列、动态重建手-物状态,以及恢复可形变物体的几何细节。该工作在包含刚性体和可形变物体的6类共24种物体上进行了训练和实验,所有序列的平均重建误差仅为1.8厘米,表明了该系统在操作不同形变程度的物体时,具有较强的普适性,能够有效复现人类操作的经验。

图3 视觉-触觉联合学习框架的流程

图4 基于ViTaM系统的手-物重建结果

图4展示了基于ViTaM系统进行手-物重建的结果,分别从有无应变干扰抑制方面、连续形变方面以及纯视觉与视触融合多模态方面进行了分析,显示出视觉-触觉联合深度学习具有明显的优势。最后展示了在真实世界中收集的视觉-触觉数据重建的序列结果,证明了该方法在处理多帧数据时的时空一致性。未来,ViTaM系统将被集成到人形机器人的电子皮肤中,实现与周围环境的无缝互动,提升机器人灵巧操作能力,推动机器人从操作特定物体到通用操作场景的技术进步。

评论

文明上网理性发言,请遵守新闻评论服务协议

登录参与评论

0/1000