近期,杭州深度求索人工智能(AI)基础技术研究有限公司(DeepSeek)先后上线大语言基座模型DeepSeek V3,以及基于V3训练、专为复杂推理任务设计的DeepSeek R1模型,并同步开源。它们以卓越的性能超越或媲美全球顶级的开源及闭源模型。

DeepSeek的开源之举将使得AI像水和电一样触手可及,为实现“时时、处处、人人可用的普遍智能”带来曙光。它在模型算法和工程优化方面所进行的系统级创新,为在受限资源下探索通用人工智能开辟了新的道路,并为打破以“大模型、大数据和大算力”为核心的生成式AI扩展定律天花板带来了无限遐想。

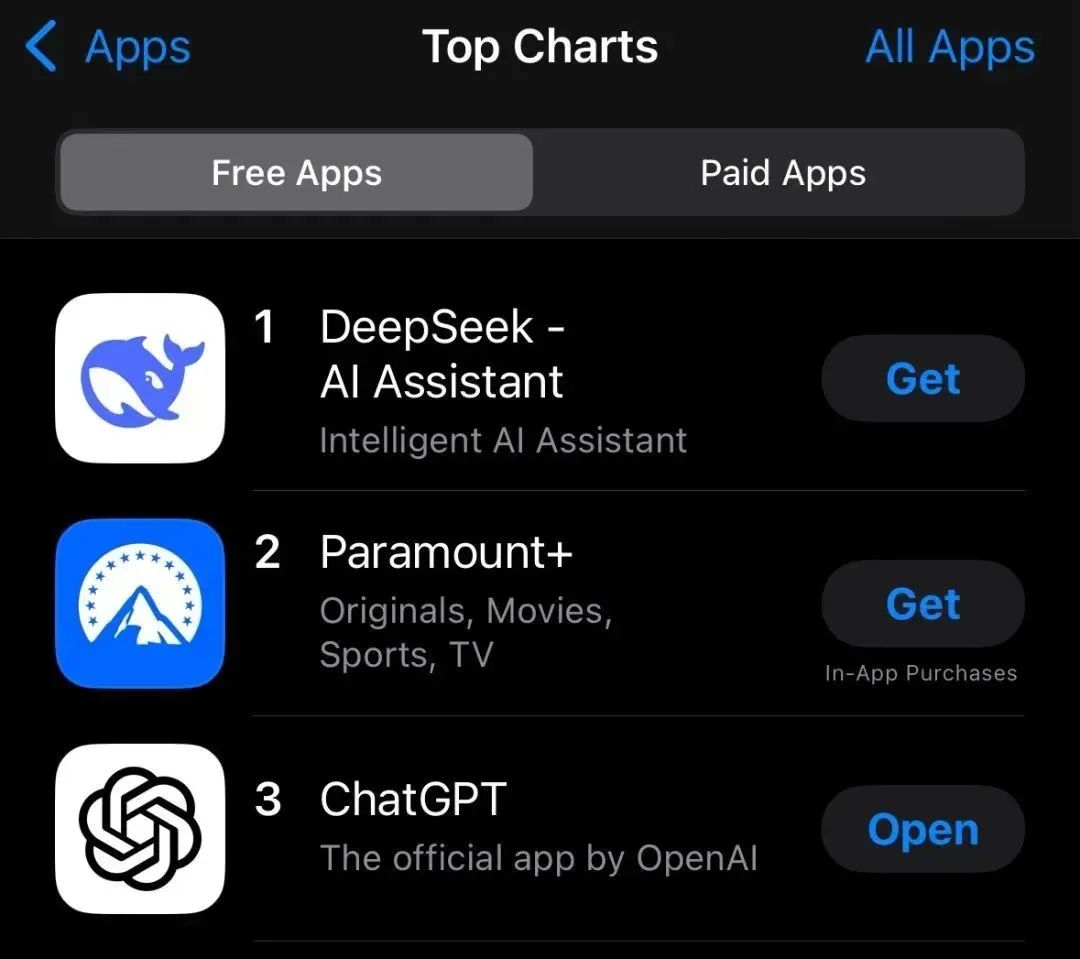

过去几周,DeepSeek应用登顶苹果美国地区应用商店免费App下载排行榜,在美区下载榜上超越了ChatGPT。1月28日,美国“外交学者”(The Diplomat)网站发表题为《中国的DeepSeek是美国人工智能的“斯普特尼克时刻”》的文章指出,DeepSeek此次的开源之举延续了OpenAI的初心使命——为了人类利益推动人工智能发展。

2025年1月27日,DeepSeek应用登顶苹果中国地区和美国地区应用商店免费App下载排行榜,在美区下载榜上超越了ChatGPT 图源:中央广电总台中国之声

DeepSeek的出圈,再次印证了一个科技创新道理:赢得比赛的关键是精益求精、富有创造力的创新,而非单纯的金融实力和一味的出口管制。

“大力出奇迹”并非AI唯一出路

2019年,人工智能领域强化学习鼻祖、Deepmind研究科学家,加拿大阿尔伯塔大学计算机学教授理查德·萨顿发表了一篇题为《苦涩的教训》的文章,认为“纵观过去70年的AI发展历史,想办法利用更大规模的算力总是最高效的手段”。

在“数据是燃料、模型是引擎、算力是加速器”这一深度学习理念支持下,以Transformer为基本模型的生成式AI(如ChatGPT等)不再从互联网中搜索和罗列已有匹配信息,而是从海量数据中洞悉单词与单词之间的共现概率,以组合意义下“昨日重现”方式合成众所周知的语言内容。

Transformer是2017年谷歌公司提出的一种新型深度神经网络,其核心在于通过自注意力机制让每个单词记住在不同语境下的“左邻右舍”,然后以似曾相识之感来概率合成新的内容。“Transformer”这一名字或许受到了2007年于美国上映的电影《变形金刚》的英文名“Transformers”的启发,因此可以将合成内容的生成式AI看成一个“魔镜”,它能够根据输入内容犹如变换魔术般输出与之对应的输出内容。

由于每个单词要记住越来越多不同语境下的“左邻右舍”,因此模型参数不断增多而导致模型规模不断增大,随之出现了大模型的“扩展定律”(scaling law),即随着模型规模、训练数据和计算资源的增加,模型性能会得到显著提升, 并且这些关系遵循可预测的模式。

面对越来越大的模型,训练模型所需的AI算力不断飙升,“大力出奇迹”这一算力霸权开始左右人工智能的发展。英伟达创始人兼首席执行官黄仁勋就据此提出过“黄氏定律”:在计算架构改进的推动下,人工智能芯片的性能每年可提升1倍,速度远超摩尔定律。

人工智能扩展定律虽然也需要算法和系统的创新,但是这一“无他、但手熟尔”的模式应该不是人工智能发展的唯一出路,因为“化繁为简、大巧不工”才是推动“机器学习”迈向“学习机器”的初衷。

万物之始,大道至简,衍化至繁,以简单直接思路解决复杂问题才是科学研究之道。1953年,获得1938年诺贝尔物理学奖的恩利克·费米提到,冯·诺依曼曾对他说过,用四个参数就可以画出一头大象,用五个参数就可以让大象鼻子动起来。英国数学家雅各布·布鲁诺斯基也曾提到,冯·诺依曼认为围棋不是博弈,虽然因为计算复杂而难以找到答案,但在理论上,下围棋一定有个最佳落子方案。

这些故事告诉我们,用简单方法解决复杂问题是科学研究基本思路之一,正如爱因斯坦所言,“所有科学中最重大的目标就是从最少数量的假设和公理出发,用逻辑演绎推理的方法解释最大量的经验事实”。由此可见,DeepSeek的研发初心切合了大模型发展的内在逻辑,为遏制其“疯长”势头提供了一剂良药。

从“学而不思则罔”到“思而不学则殆”

能用众力,则无敌于天下矣;能用众智,则无畏于圣人矣。DeepSeek的精彩表现在于其对算法、模型和系统等进行的系统级协同创新,是众智和众力相互叠加的成果。

应该说,DeepSeek模型仍是基于美国谷歌公司于2017年提出的Transformer架构,没有实现改变游戏规则的颠覆性基础理论创新。但是,它在模型算法和工程优化方面进行了系统级创新,在2048块英伟达H800 GPU(针对中国市场的低配版GPU)集群上完成训练,打破了大语言模型以大算力为核心的预期天花板,为在受限资源下探索通用人工智能开辟了新的道路。其算法和工程创新主要包括了混合专家模型、低秩注意力机制、强化学习推理、小模型蒸馏,以及诸如FP8混合精度和GPU部署优化等工程创新。

混合专家稀疏模型与传统大语言模型所采用“众人拾柴、咸与维新”不同,它另辟蹊径采取了“术业有专攻”理念,每次让若干个合适专家协作发挥各自能力,完成特定任务。

DeepSeek的基座模型V3采用了混合专家机制,每一个Transformer层包含256个专家和1个共享专家,V3基座模型总共有6710亿参数,但是每次token仅激活8个专家、370亿参数。这一创新算法与稠密模型相比预训练速度更快,与具有相同参数数量的模型相比,则具有更快的推理速度。

实际上,人脑也是一个稀疏模型。虽然人脑由800多亿个神经元和100万亿个突出连接而成,但它在完成识人辩物和举手投足等任务时,每次只有一小部分神经元被激活。实现“弱水三千,只取一瓢饮”,且让被选择若干专家能够以“十个指头弹钢琴”形式负载均衡地合作完成任务,而不是“三个和尚无水喝”——这正是DeepSeek所做出的难得的算法创新。

低秩注意力机制的引入使DeepSeek在保持模型性能的同时显著降低了计算和存储成本。

低秩注意力机制又被称为多头潜在注意力机制。人类在对外界信息理解时,往往看到的是内嵌在信息中的本质结构。例如,我们在理解一篇文章,更关切单词所刻画的主题概念,而非单词从头到尾的罗列等。传统大模型中的注意力机制由于需要记录每个单词在不同上下文中的左邻右舍,因此其变得庞大无比。DeepSeek引入低秩这一概念,对巨大的注意力机制矩阵进行了压缩,减少参与运算的参数数量,从而在保持模型性能的同时显著降低了计算和存储成本,把显存占用降到了其他大模型的5%-13%,极大提升了模型运行效率。

在强化学习推理方面,传统大模型方法训练时采用了“授之以鱼,不如授之以渔”的方法,即人类给出大量思维链数据,通过监督式微调来让大语言模型仿照思维链完成相应任务。但DeepSeek这次在训练推理模型中直接采用了一条前所未有的“纯”强化学习路径,仅根据模型输出答案优劣以及输出答案格式完整等简单信息,对模型行为进行奖惩。

这一做法如同让一个天才儿童在没有任何范例的指导下,完全通过“尝试与试错”来不断探索未知空间,并利用已有经验不断取得进步,最终完成从“摸着石头过河”到“先知后行”的蝶变。而且,DeepSeek进一步提出了让模型从若干答案中进行比较的选择方法,以实现自我提升。

这种直接训练方法不仅完成时间更短、计算资源需求大幅减少,更让模型学会了思考,而且是以见证“啊哈时刻(Aha Moment)”(指让用户眼前一亮时刻)的顿悟方式思考,并会用人类易懂的方式表达思维过程。

但值得注意的是,该方法难免导致推理过程难以被溯源和理解等局限性。为此,DeepSeek收集了一部分思维链数据,引入冷启动和有监督微调等方法,对模型进行再次训练,从而让模型在保持强大推理能力的同时,还学会了用人类易懂的方式表达思维过程。

广受关注的“模型蒸馏”就是让小模型模仿大模型回答问题的结果,来提升自身能力。比如,在对一篇文章分类时,大模型认为该文章以85%、10%和5%的概率分别属于正面、负面和中性等不同情感类别。小模型就从大模型输出的结果中认真思考,不断调整参数,以期望继承大模型能力,从而输出类似结果。

由于神经网络有强大非线性映射能力,蒸馏学习不仅没有导致“东施效颦”的笑话,反而使得大模型的能力之道以“他山之石、可以攻玉”蒸馏之术迁移到了小模型。这不禁让人感叹,对于大模型而言,“学而不思则罔”;对于小模型而言,“思而不学则殆”。

算法创新克服大语言模型扩展定律还需要工程创新。为此,DeepSeek使用FP8混合精度加速训练并减少GPU内存使用,使用DualPipe算法(即将前向和后向计算与通信阶段重叠以最大限度地减少计算资源闲置)提升训练效率,并进行了极致的内存优化。他们开发了一套完善的数据处理流程,着重于最小化数据冗余,同时保留数据的多样性。

“精彩一跃”开辟“普遍智能”新路径

尽管DeepSeek模型基于Transformer架构,并非颠覆性基础理论创新,但是DeepSeek的确是AI漫漫征途中精彩一跃,也为AI未来发展带来了深刻启示。

事实上,AI迄今所取得的成就都是过往一次次“精彩一跃”所绘就而成。去年,诺贝尔物理学奖授予AI就是这样一个注解:约翰·霍普菲尔德和杰弗里·辛顿分别从物理学能量最小和玻尔兹曼分布角度去优化神经网络模型参数,为当下深度学习的崛起打下了坚实的历史桩基。

今年1月25日,《经济学人》杂志在《中国人工智能产业几乎已追上美国》一文中使用了一幅图片——一条龙出现在一辆车的后视镜中,借此暗指中美AI发展之间距离已经相当接近。不过,文章又用“穿着高跟鞋倒退跳舞的金杰·罗杰斯”来暗喻,在AI发展过程中,美国OpenAI等人工智能巨头付出了更多努力或承担了更多责任,而现在DeepSeek却得到了更多赞誉或关注。

“夫水之积也不厚,则其负大舟也无力”,在为DeepSeek成功喝彩的同时,我们也要为推动人工智能发展的所有努力而喝彩,每个人的努力均不可忽视。

长久以来,人们一直认为,“从0到1”的理论创新是推动AI发展的引擎,但事实上工程创新也是不可或缺的推动力量。DeepSeek在架构设计和工程优化上进行的系统性创新,就是为了实现在资源受限情况下完成对标一流大语言模型性能的任务,他们用创新改变了大语言模型依赖算力的固有路径。

中国工程院院士、中国工程物理研究院研究员李幼平曾经讲过一个故事:他曾请教我国“两弹一星”元勋、两院院士朱光亚先生,为什么九院称“工程物理研究院”。朱光亚先生回答:“物理是深度,工程是规模——没有规模,做不成大事。”

由此可见,在算力成本呈指数级增长的人工智能领域,通过算法优化、架构突破和工程创新降低大语言模型成本,这本身就是技术实力的体现,是难能可贵的大事。

更让人激动的是DeepSeek将工程创新成果开源,以此加速技术落地和迭代升级。现在,任何人均可从DeepSeek网站自行下载与部署模型,网站提供了详细说明训练步骤与窍门的文档。

可以预见,DeepSeek不同大小模型将被部署为不同场景中的人工智能基座,大家都可通过行业自有数据、知识和经验进行专业训练和微调,从而创造无限可能。

如果说,传统大模型遵循的是一条“由通到专”的人工智能发展思路,那么DeepSeek的做法将推动形成一条“由专到通”的人工智能发展路径,通过牵引人工智能技术生态形成,迈向全社会分享的普遍智能之路。

智能时代,教育何为?

人工智能是一种类似于内燃机或电力的“通用目的技术”,天然具备“至小有内,至大无外”推动学科交叉的潜力,无论是从人工智能角度解决科学问题(AI for Science,如利用人工智能预测蛋白质序列的三维空间结构),还是从科学的角度优化人工智能(Science for AI,如从统计物理规律角度优化神经网络模型),未来的重大突破都将源自于这种交叉领域的工作。

如果说过往的技术发明是从机械化增强角度在提升人类与环境的互动能力,那么人工智能的出现却对人类的这一根本能力和角色发起挑战——生成式人工智能的出现使得智能机器成为知识生产的辅助者,将深刻改变个体学习者的自主思考、判断、学习能力,乃至伦理道德观。

如何看待一项新技术的发展,这是进行技术预测一项必需的认知准备。遗憾的是,我们人类总是习惯于线性思维(这符合人类自然的认知模式:节省能量与快速计算)。但是,这种认知配置很容易出现认知偏差,其中最常见的就是对于技术近期与远期影响的判断出现不对称性——短期内我们倾向于高估技术的影响,长期内我们低估技术的影响,即美国科学家罗伊·阿玛拉提出的“阿玛拉法则”。

那么,随着智能时代的来临,如何通过教育体系的变革来应对这一时代之变?在浙江大学于2024年6月发布的《大学生人工智能素养红皮书》中,我们提出,大学生人工智能素养是由体系化知识、构建式能力、创造性价值和人本型伦理构成的有机整体,其中知识为基、能力为重、价值为先、伦理为本。

目前,浙江大学和复旦大学等高校已将人工智能作为全校大学生通识必修课程。而且,浙江大学、复旦大学、上海交大、南京大学、中科大和同济大学已在四年前共同推出“课程共建、学分互认、证书共签”的AI+X微专业,今年还将推出升级版,进一步加强人工智能通识教育和交叉学科教育。

2024年春节,我为文汇报撰写《Sora“超级涌现力”将把AI引向何方》的文章,今年春节又为DeepSeek撰稿。虽然希望人工智能年年有精彩,但我更期盼全